Создаём файл robots.txt

теги: файл robots.txt, создать robots.txt, генератор robots.txt

Файл robots.txt — текстовый файл, расположенный в корневой папке сайта, который предназначен для роботов поисковых систем. В этом файле мы прописываем правила индексирования нашего ресурса, как для всех роботов, так и для каждой поисковой системы по отдельности.

-

Файл robots.txt своими ручками

-

Создаём robots.txt с помощью генераторов

Пишим robots.txt своими ручками

В этой главе я не буду расписывать правила и дерективы для robots.txt, просто приведу пример и дам полезные ссылки на ресурсы в которых подробно описывается создание robots.txt своими ручками. От правильного написания robots.txt зависит дальнейшая индексация вашего ресурса поисковиками. Поэтому, по возможности внимательно изучите директивы robots.txt для Yandex и Google.

В простом файле robots.txt используются два правила:

User-Agent: определяет робота для которого применяется следующее правило исключения

Disallow: каталоги и url, которые хотим закрыть от индексации

Пример с объяснениями:

User-agent: Yandex

Disallow: /next

# запрещает индексацию Яндексу ссылок, которые начинаются с «/next»

# если запретов несколько, то каждый Disallow прописываем с новой строки

User-agent: Yandex

Disallow:

# пустое поле Disallow разрешает Яндексу индексировать все ссылки

User-agent: *

Disallow: /next

# запрещает всем роботам индексацию ссылок, которые начинаются с «/next»

и так далее, смотрите директивы для Google и Yandex.

Директивы robots.txt для Google

Директивы robots.txt для Яндекс

Проверить robots.txt на Яндекс.Вебмастер

Стандарт исключений для роботов

Правильный robots.txt для WordPress

Создаём robots.txt с помощью генераторов.

Генератор — это сервис, который создаёт валидный файл robots.txt для нашего ресурса.

a). Идём по адресу http://4seo.biz/tools/15/

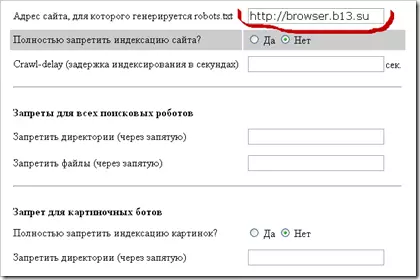

b). Я буду создавать robots.txt на примере странички http://browser.b13.su. Пишем в строке адрес своего ресурса.

c). Выставляем нужные нам настройки

d). Директива Host(на ваше усмотрение) директивы для robots.txt на Яндекс.Вебмастер

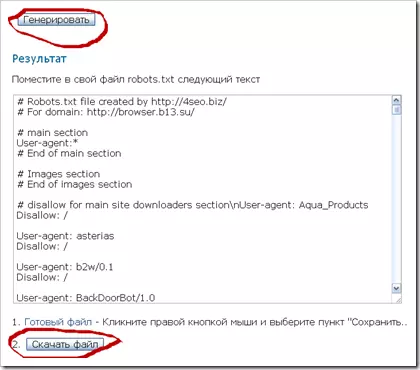

e). Жмём кнопку, генерировать. Всё, robots.txt готов! Скачиваем файл на компьютер.

Второй сервис — генератор robots.txt

Идём по адресу http://www.seolib.ru/script/robots/?page=robots

На этом сервисе суть та же, что и на первом, поэтому расписывать его смысла нет. Но, он немного другой, поэтому советую с ним поработать тоже.

Заключительная часть:

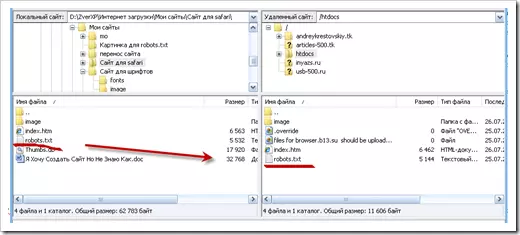

Теперь нам нужно разместить файл robots.txt в корневую папку сайта. Открываем ftp-клиент и закачиваем файл на сервер.

Инструкция для роботов готова! Надеюсь, информация для вас будет полезной.

Сайт: Сервисы для Веб-Мастера

Рубрика: Файл robots.txt

Статья: Создаем файл robots.txt

генератор robots.txt

Сервисы для Веб-Мастера feedbackна платформе

Сервисы для Веб-Мастера feedbackна платформе

Один комментарий к “Создаём файл robots.txt”

пасибо